Wenn du eine eigene Website betreibst, möchtest du im Regelfall, dass Leute sie besuchen. Mit Adwords geht’s schnell, ist aber teuer. Einer der wichtigsten Trafficlieferanten – wenn nicht der wichtigste Lieferant – ist die Google Suche. Earned traffic, Besucher, die du dir verdienst.

Es ist naheliegend, dass du versuchst, mit Suchbegriffen, die für deine Site wichtig sind, auf Seite eins der Googlesuchergebnisse ganz oben zu erscheinen. Denn nur die Treffer, die da oben angezeigt werden, haben die Chance angeklickt zu werden. Alles andere kannst du vernachlässigen.

Alte Suchmaschinentricks, die die heute vergessen kannst

Es gab eine Zeit, in der man sich einige Tricks ausgetauscht hat, um seine Position im Ranking zu verbessern, wie der SEO sagt. Ganz viele Links von anderen Seiten auf diese Domain setzen lassen, war eine der zentralsten Empfehlungen, die du sicher auch kennst. Eine andere lautete, dass du das Keyword, mit dem du gefunden werden willst, ganz oft in der Zielseite unterbringen musst, allerdings nicht zu oft. Die „Keyworddichte“ darf einen kritischen Wert nicht überschreiten.

Sowas hat damals, und so lange ist das noch gar nicht her, sehr gut funktioniert. Es gab richtige „Linkfarmen“, Seiten, die nur angelegt wurden, um massenhaft Links auf die zu optimierende Domain zu organisieren und dies als Geschäft anzubieten. Es wurden irrsinnig sinnlose Domains und Seiten angelegt, mit Content, der das Wort nicht verdient. Es war so schlimm, dass von Webspam gesprochen wurde.

Guter Content ist wohl nicht genug

Build and they will come – von wegen!

Google handelte und hat nutzlose Seiten und Seiten, die sichtlich nach oben manipuliert worden waren ohne einen Mehrwert zu bieten, ausgefiltert. Die SEO-Branche war verunsichert. Google mit dem Webmastergesicht Matt Cutts ging an die Weböffentlichkeit und proklamierte, dass man nur „großartigen Content“ präsentieren müsse und die Besucher kämen dann schon von ganz alleine. Dass dem nicht so ist, hat sich schnell herausgestellt. Es braucht schon externe Signale, wie man sagt. Links meint man meist damit.

Außerdem wurde Google aggressiver und hat Seiten „abgestraft„, wenn man in Mountain View der Meinung war, ein unzulässige Manipulation, einen Verstoß gegen die heiligen Webmaster-Richtlinien gefunden zu haben. Entfernt haben die Googler das Linkziel, was für eine E-Commerce-Seite das Todesurteil bedeuten konnte.

Einige SEOs und Seitenbetreiber haben das angenommen und umgesattelt: Entweder sie haben wirklich gute Inhalte mit mehr Qualität erstellt oder sie schwenkten auf Social Media um, wo man recht einfach und ganz heftig bullshitten Content en masse abwerfen konnte. Ein paar seltsam-provokante oder herzzerreißende, kitschige Bilder und ein Bait wie „Was danach geschah, erwartete keiner“ genügten. „SEO ist tot“, riefen manche. Und viele haben das geglaubt.

(Berechtigte) Angst vor Panda

Nach dem berühmt-berüchtigten Panda-Update der Google-Suche waren die Manipulationsnetzwerke offengelegt. Eingehende Links konnten toxisch sein, man bemühte sich eilig, diese entfernen zu lassen.

Links auf einer Seite auf eine andere sanken in der gefühlten Wichtigkeit. Es trat das ein, was zum Beispiel Marco Jank als „Linklähmung“ bezeichnete. Man kümmerte sich weniger um Verlinkungen, sattelte lieber um auf das neue Pferd – oder auch das Goldene Kalb – „Content Marketing“ und produzierte „holistischen Content„.

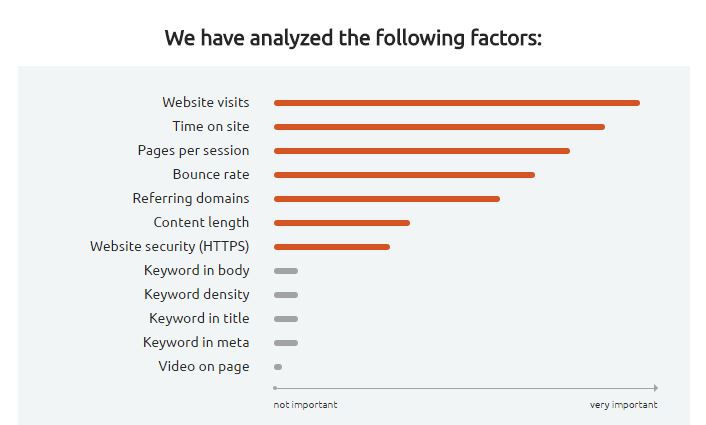

Links, die von einer Seite auf eine andere zeigen sind allerdings immer noch eines der härtesten Kriterien, die Google anlegt, um die Reihenfolge der Treffer auf den Suchergebnisseiten festzulegen. Die Relevanzabschätzung erfolgt ganz offensichtlich nach wie vor anhand von mittlerweile als „klassisch“ zu bezeichnenden Kriterien, auch wenn die Erkennung minderwertiger Seiten und Inhalte stark verbessert worden ist. Das zeigt auch eine aktuelle Untersuchung, die SEMRush (Hersteller eines SEO-Tools) veröffentlicht hat.

Methodisch kannst du dir das so vorstellen: Man stellt fest, welche Seiten für eine große Anzahl möglicher Suchbegriffe welche Position auf den Suchergebnisseiten ergeben. Zudem untersucht man, diese Seiten anhand verschiedener Kriterien, von denen man einen Einfluss auf die Position vermutet.

Was erfolgreiche Seiten – im Sinne von SEO – gemeinsam haben. Analysiere und lerne!

In der besagten SEMRush-Rankingfaktoren-Studie ergibt sich ein sehr starker Zusammenhang zwischen der Anzahl der Besucher einer Website und der Suchergebnisposition: Je mehr Besucher, desto höher die Position. Das ist wenig überraschend und argumentiert eher zirkulär: Obere Treffer werden nun einmal bevorzugt angeklickt, was ihren Traffic erhöht.

Bei den folgenden Kriterien wird es schon spannender, genauer gesagt bei Time on site, Pages per session und Bounce Rate. Diese drei Kriterien sind nicht unabhängig voneinander, bilden aber unterschiedliche Facetten des Verhaltens des suchenden Seitenbesuchers ab – was steckt dahinter?

Die Bouce Rate gibt an, zu welchem Anteil die User, die von der Suchmaschinenergebnisseite zur Trefferseite gelangt sind, diese Seite wieder verlassen ohne eine weitere Seite anzusehen und zur Suchergebnisseite zurückkehren (per Browserschaltfläche). Das kann man als Google sehr gut feststellen. Wenn eine Seite eine hohe Bouncerate aufweist und die User schnell zurückkehren, kann man erwarten, dass auch die mittlere Verweildauer auf der Seite kurz ausfällt. Das ist der Wert Time on site. Die Angabe Pages per session, also Anzahl besuchter Einzelseiten auf einer Website dürfte im Schnitt ebenfalls gering ausfallen, wenn die User im Schnitt auf dieser Seite nicht lange bleiben.

Diese drei Kriterien weisen einen sehr hohen Zusammenhang mit der Suchergebnisposition auf: Niedrige Boucerate, viel Zeit auf der Seite, viele Seitenansichten – das hängt mit einer Position zusammen, die weit oben ist. Halte also die User auf der Seite, lass klicken, biete ihnen etwas an, was sie interessieren könnte, das könnte man als Empfehlung daraus ableiten. Allerdings: Es sind Zusammenhänge festgestellt worden, keine Ursache-Wirkung-Beziehung. Correlation is not causation, sagt der Data Analyst.

Drei weiteren Eigenschaften kommt hohe Bedeutung zu. Zum einen ist dies die Anzahl der eingehenden Verlinkungen, abgebildet als referring domains. In der Darstellung von SEMRush nur etwas weniger wichtig sind der Umfang des Inhalts sowie die Verwendung des HTTPS-Protokolls, also einer verschlüsselten Datenübertragung zwischen Server und Browser (bei goneo kannst du übrigens SSL-Zertifikate von Let’s Encrypt mittels Kundencenter leicht einbinden).

Wenig Zusammenhang zwischen Suchmaschionenposition und Seiten- bzw. Inhaltseigenschaften fanden die Analysten hinsichtlich Krtierien, die sich um Keywords drehen. Ob der Suchbegriff im Body-Element (also im HTML-Inhalt zwischen <body> und </body>) vorhanden ist oder nicht oder wie oft das Keyword prozentual vorkommt, scheint fast egal zu sein. Auch ob das Keyword im Meta Tag Bereich verwendet wird oder im Title-Tag scheint keine Bedeutung für die Abschätzung der Relevanz zu haben. Das kannst du dir also auch sparen.

Fazit

Es lohnt sich, sich damit zu beschäftigen, wie man für bestimmte Suchbegriffe obere Positionen auf der Ergebnisseite von Google zu diesem oder verwandten Suchbegriffen erhalten kann. Dies ist nachhaltiger also die Buchung von bezahlten Suchtreffern, erfordert aber, dass man tatsächlich das Interesse des suchenden Users erfüllt. Sonst klickt er im Browser auf „zurück“ und landet wieder auf der Trefferliste, was Google als Signal dafür wertet, dass diese Seite diesem User wohl nicht geholfen hat.

Mittlerweile unterschätzt wird das Kriterium eingehende Links: Wenn andere Webseiten auf eine Website verlinken, scheint dies mit guten Positionen in der Suchtrefferliste von Google einherzugehen.

Weitere Informationen

Im Web gibt es viele Seiten und Blogs, die sich mit Suchmaschinenoptimierung beschäftigen. Auch SEMRush, die die zitierte Studie angefertigt haben, betreiben einen Blog, der viele Anhaltspunkte zur Verbesserung der Suchmaschinenfreundlichkeit bietet.

Ganz essentiell ist ein Konto bei der Google Search Console. Früher hieß dieses Angebot Google Webmaster Tools. Hier findet man eine Auswertung darüber, wie viele und welche Suchanfragen in der Googlesuchmaschine zu einer Ausweisung deiner Seite als passender Treffer geführt haben, mit Positionsangabe, Klickzahl und Klickrate. Das Angebot ist kostenlos und bietet ein Vielzahl weiterer nützlicher Funktionen.

Wer Tipps lieber hören als lesen will, kann sich den Wayne-Podcast von Marco Janck abonnieren, zum beispiel bei iTunes oder die einzelnen Folgen auch im Web hören.

Abonniere diesen Blog, um auf dem laufenden zu bleiben. Wir schreiben anbieterunabhängig über Tools, Methoden und Ideen. Der Link zum Abonnieren ist ganz unten auf dieser Seite. E-Mailadresse genügt.