Im Mai 2018 hat Ahrefs, ein Anbieter von SEO-Onlinetools einen Blogbeitrag über Traffic auf Websites veröffentlicht. Die zentrale Aussage war, so auch in der Überschrift, dass 91 Prozent aller Webseiten keinen Traffic von Google bekommen würden (https://ahrefs.com/blog/search-traffic-study/).

So kam Ahrefs zu dieser Aussage

Das 90 Prozent aller Websites ignoriert werden, mag erschreckend klingen. So viel Arbeit so umsonst. Grund also, der Sache nachzugehen und Gegenmittel zu finden.

Ahrefs hat ein Tool in Angebot namens „Content Explorer“, mit dem man als Nutzer oder Kunde des Anbieters den beliebtesten Content im Netz zu bestimmten, selbst festzulegenden Themen finden kann.

So funktioniert das: Ahrefs schickt eigene Spider los, crawlt das Web also selbst – ähnlich wie Google für den Suchindex – und fügt der Datenbasis für den „Content Explorer“ nach eigenen Angaben 1,8 Millionen neuer Seiten pro 24 Stunden hinzu. Die anderen Ahrefs-Crawler würden diese Menge an Information in ganz neuen Seiten pro Minute durchsuchen.

Diese Datenbasis, die einen Umfang von etwa einer Milliarde Seiten habe, nahm Ahrefs und untersuchte die Ergebnisseiten von Google daraufhin, ob die Seiten als Ergebnis ausgewiesen werden. Ahrefs fand, dass von diesen Seiten 90,88 Prozent in keinem Fall als Suchergebnis auftauchten. Daher die Aussage, dass über 90 Prozent aller Websites keinen Traffic von Google erhalten.

Die Analyse der Google-Suchtreffer nimmt man für gewöhnlich so vor: Man schickt automatisiert massenhaft Anfragen an die Googlesuche zu den unterschiedlichsten Suchbegriffen. Dann liest man aus den Ergebnisseiten herausliest, welche URLs als Treffer gezeigt werden, und an welcher Position auf der Suchergebnisseite. Scraping nennt man diesen Vorgang.

Als zugrunde liegende Suchbegriffe nimmt man normalerweise ein Set von mehreren hunderttausend Keywords, die nach bestimmten Kriterien zusammengesucht worden waren. Meist sind es die am häufigsten verwendeten Keywords. Ahrefs gibt an, sie würden die erstaunlich große Menge an 537 Millionen Keywords einsetzen.

Ein ähnliches Verfahren nutzt das Analyseunternehmen Sistrix für den „Sistrix Sichtbarkeitsindex“, der mit 250.000 Keywords arbeitet.

Grenzen der Analysemethoden

Diese Methoden haben Grenzen. Man kann nicht beliebig viele Suchbegriffe untersuchen und auch die Zusammenstellung der Suchbegriffsbasus ist an sich schon kritisch. Aus Praktikabilitätsgründen muss man sich auch bezüglich der Suchergebnisseiten begrenzen. Oft wird nur die Seite eins der Googlesuchergebnisse ausgewertet, was allerdings auch dem Userverhalten entsprechen dürfte: Der überwiegende Anteil an Klicks auf einer Suchergebnisseite dürfte sich auf die Positionen eins bis fünf verteilen, während kaum jemand die zweite Suchergebnisseite überhaupt aufruft, geschweige denn auf einen Treffer auf Seite drei oder vier klickt.

Die untersuchte Datenbasis ist in ihrer Größe sehr eindrucksvoll, allerdings kann es nur ein Ausschnitt des gesamten Webs darstellen, sozusagen eine Annäherung an die Realität.

Für 2017 werden in diversen Quellen so um die 1,7 Milliarden Websites angegeben. Der Live-Counter unter http://www.internetlivestats.com/watch/websites/ läuft aktuell auf zwei Milliarden zu. Dabei muss man aber genau unterscheiden, was eine Website und was eine Webseite ist. Als Website wird bei dieser Zahl sozusagen eine Webpräsenz unter einem eindeutigen Hostnamen oder auch Domainnamen verstanden, die wiederum aus vielen Webeinzelseiten bestehen kann, als die einzelnen URLs (Adressen) bündelt. Im angloamerikanischen Sprachgebrauch nennt man diese Einzelseiten, meist HTML-Dokumente, meist „webpages“ oder einfach „pages“.

Als Treffer werden in der Googlesuche diese Einzelseiten ausgewiesen. Hier hat man es vielleicht mit 200 bis 300 Milliarden Einzelseiten zu tun, die das sichtbare Web umfassen könnte. Genau weiß das niemand. Die Frage ist dann, ob diese erfassten eine Milliarde Pages von Ahrefs das Web repräsentiert. Davon könnte man ausgehen, wenn die untersuchten Seiten wirklich zufällig als Testfälle ausgewählt worden wären. Das darf man vorsichtig bezweifeln. Außerdem kommt bei der Ahrefs-Analyse hinzu, dass nur diejenigen URLs einflossen, die auch auf einem Social Media Netzwerk auftauchten (so ist der Ahrefs-Dienst rund um den Content Explorer eben definiert). Das verzerrt die Darstellung möglicherweise erheblich.

Die Aussage, dass über 90 Prozent aller Webseiten nicht als Suchergebnis gefunden wurden, kann man nun mehrere Dinge ableiten.

Das Web ist longtailig

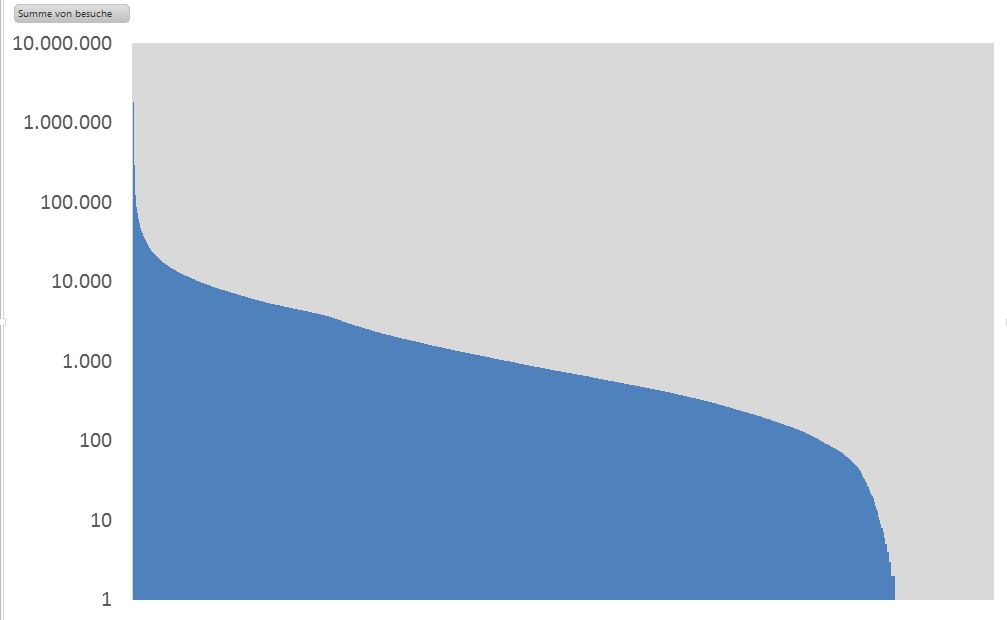

1. Wenige Seiten bekommen sehr viele Besucher , die allermeisten Seiten bekommen ganz wenige bis hin zu gar keine Besucher aus der Google Suche. Damit spiegelt sich das Phänomen „Long tail“ des Webs auch in der Google Suche. Dies ist an sich keine Neuigkeit. Erstaunlich ist vielleicht, wie stark sich der Traffic auf die Spitze konzentriert.

Dies zeigt sich auch bei unseren eigenen Analysen.

Einen ähnlichen Effekt stellt jeder Webseitenbetreiber im Kleinen selbst fest: In jedem Webauftritt gibt es ganz wenige Einzelseiten, die extrem häufig abgerufen werden, und einen langen Schwanz an allen möglichen Seiten, die sich ab und an einmal ein Besucher aufruft. Letzten Ende ist dies auch okay, denn Informationen im Web bereitzustellen, kostet kaum etwas. Man muss nur damit leben, dass vieles einfach nicht jeden interessiert.

2. Anders ausgedrückt: Der große Besucherstrom konzentriert sich auf wenige Websites. Dies sind typischerweise Websites, die ein sehr breites Interessensfeld bedienen (etwa Nachrichten, Prominente, aktuelle Ereignisse) oder Themen anbieten, die für die sehr breite Masse potentiell interessant sind (Services oder Communities).

3. In die Analyse von Ahrefs gingen alle Suchen ein. Dies hat Folgen: Google möchte mit den Top Suchergebnissen die für diesen suchenden User wahrscheinlich relevanteste Antwort geben. In die Abschätzung, welche Ergebnisse wie relevant sind, fließen viele Faktoren ein, die im Detail nach wie vor unbekannt sind. Die Analysen berücksichtigen nicht, welche Art von Suche ausgeführt wird, die diese Treffer auslösen.

Klassischerweise unterscheidet man navigatorische Suche (User weiß, auf welche Domain er möchte – was er dort möchte, verrät der Suchterminus nicht), informelle Suche (User sucht eine Information), transaktionale Suche (User möchte etwas online kaufen oder sich registrieren). Viele User nutzen Google einfach auch, um damit zu einer schon bekannten, häufig verwendeten Website zu gelangen.

4. Die Analyse unterscheidet die Website-Typen nicht. Hier stehen massenwirksame Communityseiten, Newsseiten und ähnliches neben Portfolioseiten regional bedeutsamer Anbieter.

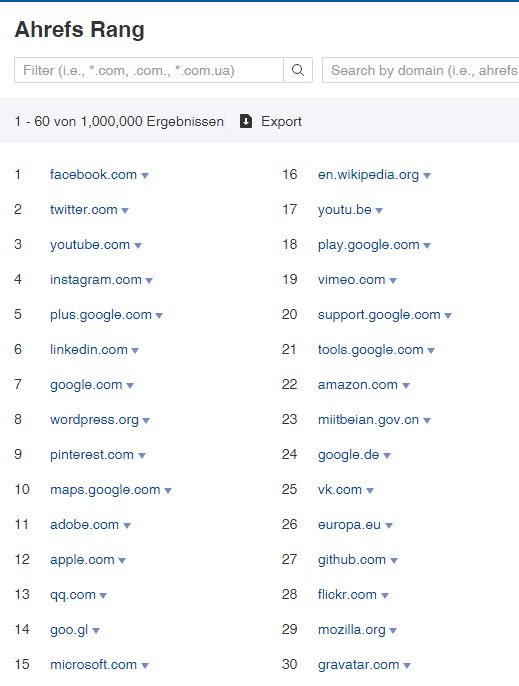

Auf Basis der eigenen erhobenen Daten formuliert Ahrefs einen Score, der den Rang einer Website im Kontext aller anderen existierenden Websites widerspiegelt (der Anbieter Alexa.com tut ähnliches).

In der Top-Liste der höchstrangigen Seiten stehen typischerweise Social Media Sites (Communities) ganz oben:

Mit den Communitysites wird allerdings keine spezielle Information gesucht oder vermittelt. Hier wird die Masse an Treffern zu Profilen mit bestimmten, gesuchten Merkmalen gehen.

Was tun?

Umgekehrt zeigt die Erfahrung, dass im Prinzip jede Website mit einem Minimum an Content mit bestimmten Suchtermina wenn nicht auf Suchposition eins, dann wenigstens auf der ersten Seite landen kann. Die wichtige Komponente, die man dazu betrachten muss, ist, die Anzahl der User, die die genau diesen Suchbegriff oder die Begriffsgruppe benutzen.

Unter zwei Milliarden existierender Websites diejenige zu werden, die am häufigsten in der Google Suche zu irgendeinem Suchbegriff auf den obersten Positionen angezeigt wird, wird schwer werden. Aber die Nummer eins in einer Nische lässt sich erarbeiten.

Entscheidend wird dann sein, auf seiner Website den Content zu zeigen, den die Gruppe der User erwarten wird, wenn sie einen bestimmten Suchbegriff eingeben und das Informationsangebot qualitativ als höher einzustufen ist als das der konkurrierenden Seiten. Bis vor einiger Zeit verließ Google sich stark auf das Pagerank-Modell (häufig verlinkte Inhalte sollten relevanter sein als weniger häufig verlinkte), doch der Algorithmus zur Relevanzabschätzung wurde von Google stark erweitert. So wurde das Verhalten der User stärker einbezogen, also das Klickverhalten und das Verweilen auf der jeweiligen Webseite

Fazit

Dass 90 Prozent oder mehr aller Websites keinen Traffic von Google bekommen, mag als Aussage stimmen. Ein hoher Anteil an Websites bekommt sehr wenig bis gar keinen Traffic, auch anderweitig nicht. Nur ganze wenige erhalten sehr viel. Die Googlesuche spiegelt hier nur den Longtaileffekt wider.

Dieser Longtaileffekt scheint typisch zu sein für das World Wide Web: Einige sehr wenige Webseiten erhalten sehr viel Traffic, viele Websites erhalten keinen oder wenig Traffic. Die Besucherzahlen sind eben nicht gleichverteilt, was auch nachvollziehbar ist. Diese Gleichverteilung finden wir eher bei Ergebnissen natürlicher Prozessen oder Bedingungen. Man kann sagen, die Körpergröße der Menschen ist gleichverteilt oder der Intelligenzquotient. Besucherzahlen auf Websites sind extrem ungleich verteilt.

Besucherzahlen auf einer Website werden „künstlich“ erzeugt, sie entstehen eben nicht zufällig: Es ist relevant, welcher Inhalt dort zu finden ist oder welcher Service angeboten wird, kurz: Welche Arbeit jemand in die Erstellung investiert. Dazu kommt wie viele User grundsätzlich an diesem Thema, das die Website behandelt, interessiert sind. Interessen lassen sich mit besonderen Mitteln erzeugen oder lenken (Stichwort: Marketing. auch SEO gehört dazu), doch auch dies erfordert Arbeit und Aufwand, die investiert werden müssen. Insofern sind die Besucherzahlen ein Ergebnis dieser Bemühungen.

Auch die Erkenntnis, dass ein großer Teil an Websites überhaupt keinen Traffic sieht, der durch die Googlesuche erzeugt wurde, ist ein Spiegel dieses Longtail-Phänomens. Es gibt viele Websites, die sehr wenige Besucher haben, mit Google oder ohne Google.

Wo also ist der Hebel zum Erfolg? Es ist sicher der Content. Content is king, sagte man in den Nullerjahren. Im Google-Sprech heißt dies: Build and they will come. Macht schöne und nutzwertige Inhalte, dann kommen die Besucher. Damit Google erkennen kann, was gute und schöne Inhalte sind, haben sie sich den PageRank-Algorithmus zu Hilfe genommen. Dieser wurde ergänzt durch die Verrechnung vieler„Signale“, wie es die SEOs gerne nennen, in komplexen (der Öffentlichkeit unbekannten) Modellen. Hauptsächlich wird in diesen Signalen das Userverhalten abgebildet. Es handelt sich um Kennwerte, die die Verhaltensspuren der User in Summe widerspiegeln so gut es geht.

Umgekehrt heißt das: Einfach eine Website zusammenzuklicken, irgendetwas als Content hinzuzufügen und im Netz zu veröffentlichen, wird keinen Erfolg bringen, genauso wenig wie es reicht, ein Unternehmen anzumelden und dann einfach gar nichts mehr zu tun, trotzdem aber auf Reichtum zu hoffen. Man muss Inhalte auf der Seite haben, die gut und schön sind. Gut im Sinne von nutzwertig und brauchbar, schön im Sinne von sinnvoll und zugänglich aufbereitet.

Eine Antwort auf „Was ist dran an der These, dass über 90 Prozent aller Websites keinen Google-Traffic erhalten?“